Hoje em dia, entender como criar um pipeline de dados eficiente é crucial. Empresas que lidam com muitas informações precisam disso. Um pipeline bem feito ajuda a gerenciar dados de forma eficiente e segura.

Isso também faz o tempo de processamento diminuir, melhorando a eficiência. A automação de processos é essencial para evitar erros humanos. Ela garante dados mais precisos.

A paralelização de tarefas pode fazer o processamento ser mais rápido. Técnicas de compressão e particionamento ajudam a economizar espaço. A implementação de cache pode diminuir o tempo de processamento em até 30%.

Escalabilidade horizontal e uso de tecnologias em nuvem são essenciais. Eles são importantes para lidar com grandes conjuntos de dados. Neste artigo, vamos explorar como criar um pipeline de dados eficiente. Vamos ver como isso pode trazer grandes resultados para sua empresa.

Principais Conclusões

- O uso de pipelines de dados é essencial para a gestão eficiente de grandes volumes de informações.

- A automatização pode aumentar a precisão e diminuir a taxa de erros humanos no processamento de dados.

- Paralelização e compressão de dados contribuem para acelerar o processamento e economizar espaço.

- A escalabilidade horizontal e a computação em nuvem são cruciais para empresas em crescimento.

- A validação automatizada garante a qualidade dos dados antes de serem utilizados em produção.

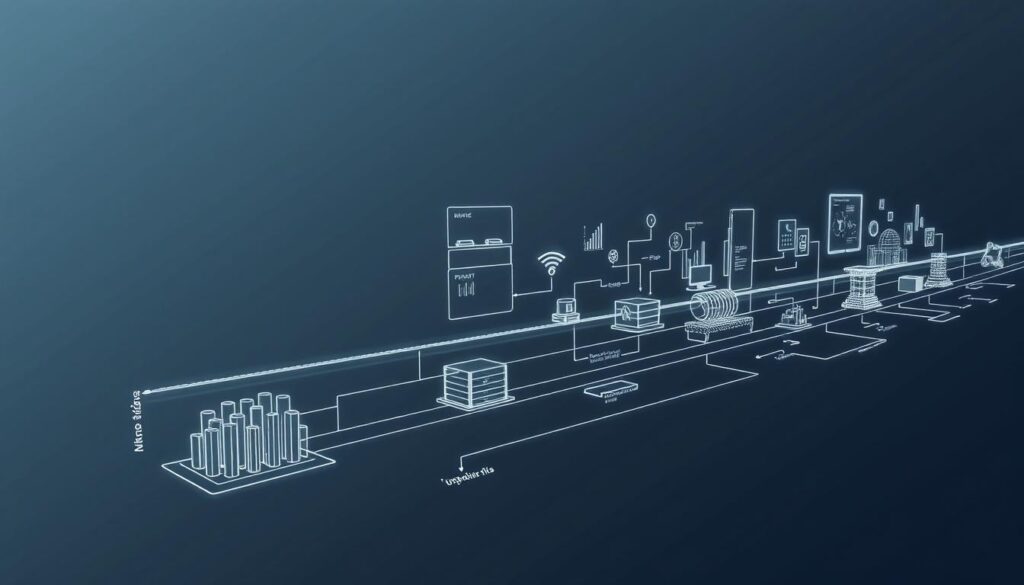

O que é um pipeline de dados eficiente?

Um pipeline de dados eficiente move e transforma dados de várias fontes para um lugar central. Isso é essencial hoje, com a definição de pipeline de dados focada em agilidade com grandes volumes de dados. Entender a importância do pipeline ajuda a otimizar negócios e a fazer análises de dados mais eficientes.

Definição de pipeline de dados

Um pipeline de dados une várias etapas, como coleta, armazenamento, transformação, análise e visualização de dados. Ele pode usar diferentes fontes, como aplicativos e bancos de dados. As soluções modernas buscam processar dados em tempo real, tornando as informações imediatamente disponíveis.

Importância para negócios

A importância do pipeline está na sua capacidade de automatizar a análise de dados. Isso diminui erros e aumenta a eficiência. Empresas com pipelines modernos têm acesso rápido a informações essenciais para tomar decisões.

Exemplos de uso

Os exemplos de uso de pipeline de dados são muitos e variados. No comércio eletrônico, integração de dados melhora a experiência do cliente. No setor financeiro, pipelines ajudam a gerenciar riscos e detectar fraudes. A Netflix personaliza recomendações de conteúdo, mostrando o impacto da análise de dados na interação com os clientes.

Principais componentes de um pipeline de dados

Os componentes do pipeline de dados são essenciais para um sistema eficiente de dados. Eles garantem a qualidade e a fluidez do fluxo de informações. Cada parte desempenha um papel crucial para o sucesso do sistema.

Fontes de dados

As fontes de dados são o início do pipeline. Elas incluem:

- Bancos de dados SQL

- APIs

- Arquivos CSV

- Streams em tempo real

Essas fontes permitem a coleta de dados variados. Pode ser estruturado, semi-estruturado ou não estruturado. A coleta pode ser programada ou feita em tempo real, tornando-a mais dinâmica.

Processamento de dados

O processamento de dados transforma dados brutos em informações valiosas. Existem duas abordagens principais: ETL e ELT.

- ETL (Extração, Transformação, Carregamento): Os dados são extraídos, transformados e carregados em um destino final.

- ELT (Extração, Carregamento, Transformação): Os dados são carregados primeiro, facilitando a análise antes da transformação.

Esse processo permite análises detalhadas e respostas rápidas às necessidades de negócios. É crucial em ambientes com grandes volumes de dados.

Armazenamento de dados

O armazenamento de dados é o último passo. Aqui, os dados são guardados em locais adequados, como data warehouses ou data lakes. Essa etapa assegura a disponibilidade dos dados para análises futuras.

Com um pipeline bem estruturado, as empresas melhoram seus processos. Eles aproveitam insights valiosos para tomar decisões estratégicas.

| Componente | Função |

|---|---|

| Fontes de dados | Coletar informações de diferentes origens |

| Processamento de dados | Transformar dados brutos em informações úteis |

| Armazenamento de dados | Guardar dados processados para análises futuras |

Passo a passo para criar um pipeline de dados

Para criar um pipeline de dados eficiente, sigo um plano detalhado. Primeiro, faço um planejamento de pipeline para definir objetivos e necessidades. Depois, escolho as ferramentas de dados mais adequadas, como Apache Airflow e Talend. Por fim, implemento o pipeline, garantindo que tudo esteja bem organizado e documentado.

Planejamento inicial

O planejamento é essencial para saber quais dados são necessários. Identifico as fontes e formatos de dados ideais. Isso define a base para o projeto, assegurando que o fluxo de informações atenda às expectativas do negócio.

Escolha das ferramentas

A escolha das ferramentas é crucial para a eficiência do passo a passo pipeline de dados. Optar por soluções como Apache Airflow ou AWS Glue melhora a automação. É importante considerar fatores como escalabilidade e suporte técnico.

Implementação do pipeline

A implementação requer atenção aos detalhes. Configuro as etapas do pipeline, desde a coleta até a transformação e armazenamento dos dados. Definir a arquitetura correta é essencial para um fluxo eficiente. A documentação ajuda a manter o processo claro para futuras manutenções.

Ferramentas populares para pipeline de dados

As ferramentas para pipeline de dados são essenciais para a automação e eficiência. Elas ajudam as empresas a integrar e processar dados de forma eficaz. Isso contribui para decisões mais informadas e rápidas. Vamos ver algumas das melhores opções do mercado.

Apache Airflow

O Apache Airflow ajuda a automatizar e agendar tarefas complexas. É uma ferramenta de código aberto com uma interface fácil. Permite a orquestração de tarefas e integração com várias ferramentas de dados.

Talend

O Talend é conhecido pela facilidade de uso em integrações de dados. Conecta-se a mais de 100 fontes de dados, tornando o ETL mais simples. Após ser adquirido pela Qlik em 2023, se tornou uma opção forte para melhorar a interoperabilidade entre sistemas.

AWS Glue

AWS Glue é uma solução ETL gerenciada, perfeita para empresas que crescem rápido. Integra-se bem com o ecossistema AWS, facilitando o processamento de grandes volumes de dados. É ótima para ambientes na nuvem.

| Ferramenta | Tipo | Principais Vantagens |

|---|---|---|

| Apache Airflow | Orquestração | Automação e agendamento de tarefas, fácil integração. |

| Talend | Integração de dados | Suporte a múltiplas fontes, interface intuitiva. |

| AWS Glue | ETL | Gerenciamento facilitado, escalabilidade em ambiente nuvem. |

Como coletar dados de forma eficiente

Coletar dados de maneira eficiente é essencial para a gestão de informações em empresas. A integração de fontes de dados une informações de diferentes sistemas. Isso fornece uma visão completa e precisa. A integração deve ser feita com cuidado, usando APIs para acessar dados em tempo real.

A qualidade dos dados é crucial para evitar problemas. Isso garante resultados precisos nas análises.

Integração de diferentes fontes

A integração de diferentes fontes de dados une informações de bancos de dados, aplicações e serviços externos. Essa abordagem melhora a coleta de dados eficiente. Ela contribui para um entendimento mais profundo das operações da empresa.

Um pipeline de dados estruturado facilita essa integração. Isso permite capturar, processar e analisar dados de forma coesa. Assim, as decisões estratégicas se tornam mais precisas.

Uso de APIs

As APIs são comuns na coleta de dados. Elas permitem que aplicações troquem informações em tempo real. As APIs garantem acesso rápido a dados externos, como informações de redes sociais e financeiras.

Essa capacidade de obter dados em tempo real é vital. Ela promove decisões ágeis em um mercado dinâmico.

Cuidados com a qualidade dos dados

A qualidade dos dados é crítica na coleta de informações. Dados imprecisos ou desatualizados podem afetar análises e decisões. Por isso, é essencial implementar práticas de validação e limpeza de dados.

O monitoramento contínuo da qualidade dos dados é fundamental. Isso garante que as informações sejam confiáveis. Uma estratégia robusta de verificação da qualidade dos dados melhora a eficiência operacional e reduz riscos.

Estratégias para processamento de dados

Para usar bem os dados, é essencial ter estratégias de processamento. Isso garante que as informações sejam boas e confiáveis. O primeiro passo é transformar os dados brutos em formatos prontos para análise.

Essa etapa é crucial. Dados não processados podem impedir de obter insights importantes.

Transformação de dados

A transformação de dados ajusta as informações para análises futuras. Inclui coisas como filtragens e mudanças de estrutura. Isso permite juntar diferentes tipos de dados de forma harmoniosa.

Usar ferramentas como Apache Airflow e AWS Glue ajuda muito nisso. Elas tornam o processo mais rápido e eficiente.

Limpeza e validação

Manter os dados precisos é fundamental. A limpeza e validação garantem que só dados corretos sejam usados. Isso evita tomar decisões com informações erradas.

Com mais dispositivos e sensores gerando dados, essa etapa se torna ainda mais importante.

Automação de tarefas

A automação de tarefas no pipeline de dados está crescendo. Ela reduz muito a carga de trabalho manual. Ferramentas como Databricks e Azure Data Factory permitem criar rotinas automáticas.

Essas tecnologias economizam tempo e melhoram a eficiência. Elas fazem o pipeline mais ágil e pronto para mudanças rápidas.

| Etapa | Descrição | Ferramentas Recomendadas |

|---|---|---|

| Transformação de Dados | Ajuste de dados brutos para análise | Apache Airflow, AWS Glue |

| Limpeza e Validação | Eliminação de inconsistências nos dados | Python, Talend |

| Automação de Tarefas | Execução automática de processos repetitivos | Databricks, Azure Data Factory |

Armazenamento: onde manter seus dados

O armazenamento de dados é essencial para um pipeline de dados eficiente. É crucial escolher o lugar certo para guardar as informações. Isso ajuda a manter as informações seguras e acessíveis. Vamos ver as melhores maneiras de armazenar dados.

Opções de armazenamento

Existem várias opções para armazenar dados, dependendo do que sua empresa precisa. Algumas das mais comuns são:

- Data warehouses para dados estruturados, que permitem consultas complexas e análises detalhadas.

- Bancos de dados relacionais, como PostgreSQL e MySQL, que são amplamente utilizados por sua robustez e confiabilidade.

- Data lakes para dados semi-estruturados e não estruturados, que permitem o armazenamento flexível de grandes volumes de dados.

Configuração de banco de dados

A configuração do banco de dados é muito importante para o armazenamento de dados. O banco deve estar otimizado para processar dados rapidamente. Isso envolve usar índices, configurar tabelas corretamente e escolher os tipos de dados certos.

A modularidade na arquitetura do banco ajuda na manutenção e na expansão. Isso permite que o sistema cresça conforme necessário.

Segurança e backup de dados

A segurança dos dados é fundamental em qualquer estratégia de armazenamento. É importante ter práticas rigorosas para proteger as informações sensíveis. Isso pode incluir criptografia e fazer backups regulares.

A segurança não é só para proteger os dados. Também é para garantir que eles estejam disponíveis quando precisarem. Com estratégias de segurança e opções de armazenamento eficazes, temos um sistema robusto e confiável.

Monitoramento do pipeline de dados

É crucial monitorar o pipeline de dados continuamente. Isso garante que as informações fluam de forma eficaz e atualizada. Detectar problemas rapidamente é essencial para a integridade e eficiência das operações. Com a complexidade dos dados crescendo, usar ferramentas de monitoramento é fundamental para manter o sistema funcionando bem.

Importância do monitoramento contínuo

O monitoramento do pipeline de dados ajuda a identificar e resolver problemas antes que eles afetem a utilização dos dados. Assim, garante-se que os dados sejam transformados e carregados corretamente. Isso fornece insights precisos aos usuários finais. Sem um monitoramento adequado, falhas podem comprometer a qualidade dos dados e a tomada de decisão nas organizações.

Ferramentas para monitoramento

Existem várias ferramentas de monitoramento que ajudam a ver o pipeline de dados. Softwares como Apache Airflow e Databricks permitem a orquestração e visualização do processo. Isso permite acompanhar cada etapa da coleta, transformação e análise de dados. Essas ferramentas ajudam a detectar problemas rapidamente e fornecem relatórios sobre o desempenho do pipeline.

Melhores práticas de alerta

Implementar práticas de alerta eficazes é essencial para agir rápido em situações de anormalidade. Configurar alertas proativos me permite receber notificações em tempo real sobre problemas. Com esses alertas, evito interrupções no fluxo de dados e mantenho a eficiência operacional. É importante personalizar esses alertas para diferentes níveis de severidade, para que a equipe reaja adequadamente.

| Ferramenta | Funcionalidade | Benefícios |

|---|---|---|

| Apache Airflow | Orquestração de fluxos de trabalho | Automatização e programação de tarefas |

| Databricks | Ambiente em nuvem para processamento de dados | Integração com diferentes fontes e escalabilidade |

| Azure Data Factory | Transformação e movimentação de dados | Interface visual para monitoramento |

Desafios comuns na criação de pipelines de dados

Na criação de pipelines de dados, enfrentamos vários desafios. Eles surgem principalmente pela necessidade de lidar com dados em tempo real. Além disso, a escalabilidade em pipelines é um grande desafio, especialmente quando o volume de dados cresce.

As mudanças constantes nas fontes de dados e seus esquemas tornam tudo mais complexo. Isso exige um planejamento cuidadoso para superar esses obstáculos.

Dados em tempo real

A demanda por dados em tempo real está em alta, principalmente em setores que precisam tomar decisões rapidamente. Ferramentas como Apache Kafka e Apache Flink são essenciais para processar esses dados rapidamente. A latência baixa é crucial para evitar atrasos que podem prejudicar as operações de negócios.

Escalabilidade

A escalabilidade em pipelines é um desafio constante. O volume de dados pode crescer muito rápido à medida que a organização cresce. Para lidar com isso, é importante ter infraestruturas baseadas em processamento distribuído, como Hadoop ou Apache Spark.

Implementar mecanismos de retry e fallback é essencial para manter o pipeline funcionando mesmo em situações adversas.

Gestão de mudanças

A gestão de mudanças é outro grande desafio na criação de pipelines de dados. Alterações nas fontes de dados ou esquemas podem causar interrupções. Usar plataformas de versionamento de esquemas ajuda a minimizar esses riscos.

Permitir atualizações sem comprometer a integridade do pipeline é fundamental. Ter uma documentação adequada e um bom planejamento são essenciais para superar esses desafios e manter a eficiência ao longo do tempo.

Boas práticas para garantir eficiência

Manter boas práticas no pipeline de dados é essencial. Isso garante a qualidade das informações. Implementar processos eficazes melhora muito o desempenho do projeto. Vejamos algumas práticas importantes para isso.

Documentação do processo

A documentação de processos é muito importante. Ela ajuda a entender o fluxo e as responsabilidades. Com uma boa documentação, a equipe pode acompanhar mudanças mais facilmente.

Isso é especialmente útil quando novos membros se juntam. Assim, o trabalho continua fluindo sem parar.

Testes regulares

Fazer testes regulares é crucial. Eles garantem que o pipeline funcione bem. Além disso, ajudam a encontrar erros antes que eles se tornem grandes problemas.

Automatizar os testes é uma estratégia eficaz. Isso mantém a qualidade dos dados e acelera o lançamento de novas versões. Isso economiza tempo e recursos.

Colaboração entre equipes

A colaboração em equipes é essencial para o sucesso. Quando TI e análise de dados trabalham juntos, as informações fluem melhor. Isso melhora a comunicação e a fluidez do trabalho.

Essa interação garante que o pipeline seja robusto e atenda às necessidades da empresa. Assim, as soluções criadas são mais eficazes.

| Práticas | Benefícios | Impacto |

|---|---|---|

| Documentação detalhada | Facilita a continuidade do trabalho | Aumenta a eficiência |

| Testes automatizados | Reduz erros e falhas | Melhora a qualidade dos dados |

| Colaboração entre equipes | Melhora a comunicação | Acelera soluções |

Como otimizar um pipeline existente

Otimizar um pipeline é essencial para sua eficiência. É preciso fazer análise de performance constante. Isso ajuda a identificar gargalos que podem atrapalhar o fluxo de dados.

Com base em dados reais, é possível fazer melhorias. Isso torna o ambiente de processamento de dados mais ágil e confiável.

Análise de performance

A análise de performance é crucial. Monitorar métricas como tempo de execução e taxa de erro é fundamental. Ferramentas adequadas ajudam a medir esses aspectos.

Isso permite saber quais partes do pipeline estão funcionando bem. E quais precisam de atenção. Manter um pipeline responsivo é essencial para sua eficiência.

Identificação de gargalos

Identificar gargalos é essencial. Processos que consomem muitos recursos ou tempo podem parar o fluxo. É importante encontrar pontos lentos ou ineficientes.

Revisar logs e relatórios de erros ajuda. Testes com diferentes cargas de dados também são úteis. Isso ajuda a identificar gargalos.

Implementação de melhorias

Com gargalos identificados, é hora de melhorar. Isso pode incluir reestruturar etapas ou usar tecnologias mais adequadas. Automatizar processos e seguir boas práticas também ajudam.

Essas ações tornam o pipeline mais robusto. Melhorar continuamente é essencial para se adaptar às mudanças nos dados.

A importância da visualização de dados

Hoje em dia, interpretar grandes volumes de dados é essencial. Ferramentas de visualização ajudam a transformar esses dados em gráficos fáceis de entender. Isso torna a análise e a comunicação de informações mais simples.

Com essas ferramentas, posso criar relatórios claros e impactantes. Eles são cruciais para tomar decisões baseadas em dados confiáveis.

Ferramentas de visualização

Tableau e Power BI são exemplos de ferramentas poderosas. Elas permitem criar dashboards interativos para visualizar dados de forma intuitiva. Essas ferramentas são essenciais para quem busca eficiência na análise de dados.

Indicadores de performance

Medir indicadores de performance é fundamental. Gráficos como barras, linhas e mapas de calor ajudam a detalhar informações complexas. Eles tornam essas informações mais acessíveis.

Essa representação visual cria um panorama claro. Permite identificar áreas que precisam de melhorias e ajustes.

Como impacta a tomada de decisão

Uma boa visualização de dados facilita a tomada de decisões estratégicas. Os dados apresentados visualmente ajudam a ver tendências e padrões. Isso torna a decisão mais rápida e assertiva.

Essa assertividade é crucial para alcançar os objetivos de qualquer negócio.

Casos de sucesso: empresas que usam pipelines de dados

Organizações que adotam pipelines de dados alcançam resultados notáveis. Vamos ver exemplos de empresas que se destacam. Eles mostram o impacto positivo e o que aprenderam no caminho.

Exemplos inspiradores

Spotify e Uber são grandes exemplos. Eles melhoraram muito com pipelines de dados. O Spotify melhora as recomendações musicais com dados. Uber, por sua vez, otimiza a rotação e diminui a espera.

Aprendizados com as implementações

Essas experiências ensinam muito. A chave é ter um fluxo de dados bem estruturado. Isso traz insights valiosos e permite adaptação rápida ao mercado. Assim, as empresas tomam decisões mais rápidas e certas.

Impacto nos negócios

O efeito nos negócios é claro. Empresas com bons pipelines de dados melhoram muito. Elas aumentam a eficiência e a satisfação do cliente. Isso leva a estratégias mais eficazes, crescimento e lealdade do cliente.

Tendências futuras em pipelines de dados

As tendências em pipelines de dados estão mudando rápido. Isso se deve à busca constante por inovação e eficiência. A inteligência artificial está mudando como analisamos dados, tornando tudo mais rápido e preciso.

A adoção da nuvem e a automação estão se tornando essenciais. Elas são fundamentais para o futuro dos pipelines de dados.

Inteligência artificial e machine learning

A inteligência artificial melhora a precisão das análises. Arquiteturas como Lambda e Kappa são essenciais para esse avanço. Elas permitem processamento rápido e eficiente.

Com machine learning, as empresas tomam decisões melhores. Isso ocorre graças a dados atualizados e em constante mudança.

Adoção de nuvem

A nuvem permite que as empresas cresçam rapidamente. Tecnologias como Apache Hadoop e Spark facilitam o gerenciamento de dados. Isso torna o armazenamento mais acessível e seguro.

Aumento da automação

A automação está tornando as operações mais eficientes. Ferramentas como Apache Airflow e Prefect ajudam muito. Elas reduzem o trabalho manual e melhoram a confiabilidade.

O monitoramento em tempo real é crucial. Ele permite ações rápidas em caso de problemas, mantendo os serviços funcionando.

| Característica | Arquitetura Lambda | Arquitetura Kappa |

|---|---|---|

| Processamento | Tempo real e em lote | Somente tempo real |

| Complexidade | Maior devido a duas camadas | Menor, mais simples |

| Uso | Análise contínua e histórica | Fluxo de dados simplificado |

Essas inovações preparam as empresas para os desafios dos dados crescentes. A combinação de inteligência artificial, nuvem e automação vai moldar o futuro dos pipelines. Elas abrirão novas oportunidades para a transformação digital.

Conclusão: O futuro dos dados nas empresas

Gerir dados de forma eficaz é essencial para empresas hoje. Neste guia, falamos sobre como melhorar a gestão de dados. Isso inclui integrar diferentes fontes, automatizar processos e garantir a qualidade dos dados.

Essas ações não só aumentam a eficiência. Elas também criam uma base sólida para análises futuras.

Com o avanço dos pipelines de dados, as empresas devem se adaptar às novas demandas do mercado. O uso de modelos como ETL e ELT é crucial para análises em tempo real ou transformação de dados. Ferramentas como Apache Airflow e soluções sem código da Astera estão se tornando essenciais.

Avançar na gestão de dados requer foco em práticas eficazes e investimento em tecnologia. Isso garante segurança, integridade e acessibilidade dos dados. Ao implementar mudanças eficazes, podemos maximizar o valor dos nossos dados. Isso leva a decisões mais acertadas nas organizações.

FAQ

O que é um pipeline de dados?

Como posso otimizar meu pipeline de dados?

Quais ferramentas posso usar para criar um pipeline de dados?

Qual a importância da qualidade dos dados em um pipeline?

Como posso monitorar meu pipeline de dados?

Quais são os principais desafios na criação de pipelines de dados?

O que devo considerar ao escolher o armazenamento de dados?

Como a visualização de dados impacta os negócios?

Especialista em Data-Driven Management e Business Intelligence, reconhecida por sua expertise em transformar dados em decisões estratégicas e vantagem competitiva para empresas. Com uma abordagem analítica e orientada a resultados, ela auxilia organizações na implementação de processos baseados em dados, desde a coleta e tratamento até a modelagem e visualização de informações. Sua atuação abrange desde a definição de KPIs e métricas de desempenho até o uso de inteligência artificial e machine learning para prever tendências e otimizar processos. Ao longo de sua trajetória, Isabel tem ajudado empresas a adotarem uma cultura data-driven, permitindo tomadas de decisão mais assertivas e impulsionando crescimento sustentável e inovação.